Naukowcy ze Stanford Internet Observatory odkryli ponad 3200 zdjęć ukazujących seksualne wykorzystywanie dzieci, ukrytych w popularnych generatorach AI. Baza danych znana jako LAION, była wykorzystywana do szkolenia wiodących generatorów obrazów takich jak m.in. Stable Diffusion.

O sprawie informuje The Guardian. W odpowiedzi na te szokujące ustalenia, operatorzy niektórych z tych generatorów szybko zablokowali dostęp do swoich zbiorów danych. Large-scale Artificial Intelligence Open Network (LAION) natychmiast usunął swoje dane, podkreślając zerową tolerancję dla nielegalnych treści.

– Nasza polityka opiera się na zerowej tolerancji dla nielegalnych treści i w nadmiarze ostrożności usunęliśmy zbiory danych LAION, aby upewnić się, że są one bezpieczne przed ponownym opublikowaniem – opublikowała platforma, cytowana przez Guardiana.

Czytaj także: Sztuczna inteligencja ewoluuje. Dr inż. Jerzy Greblicki o roli ChatGPT [WIDEO]

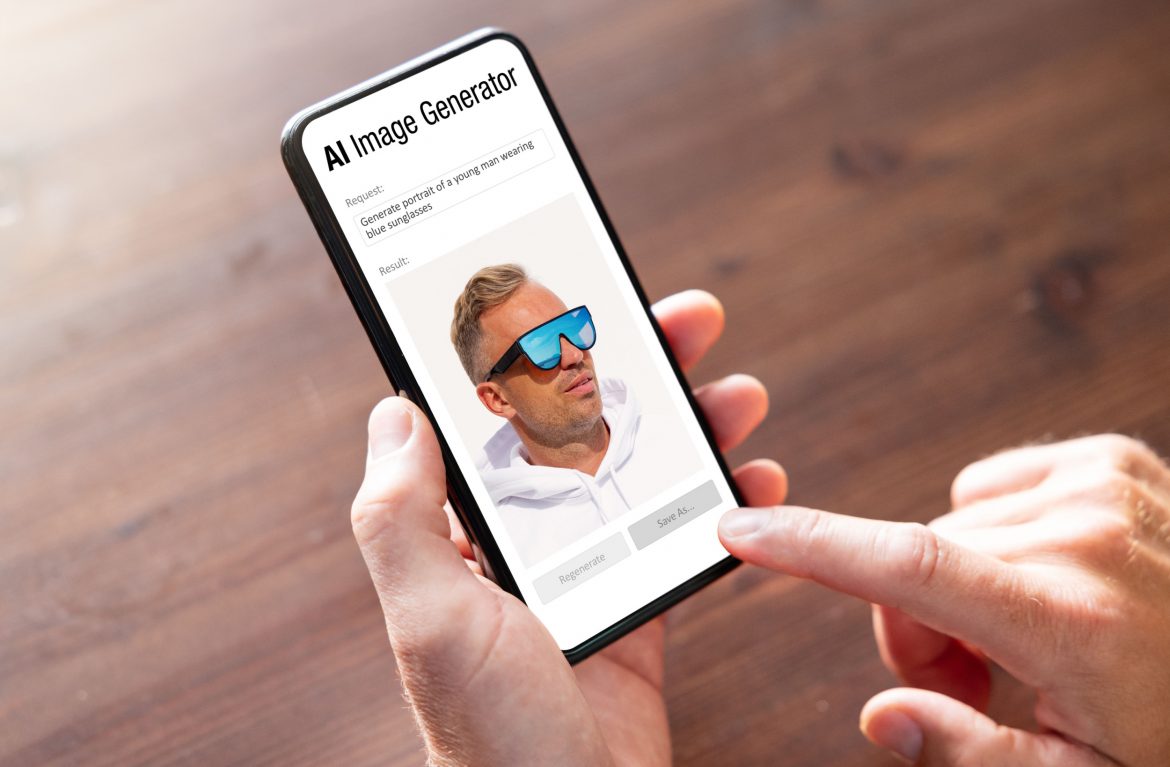

AI generuje coraz bardziej realistyczne zdjęcia

Stanford Internet Observatory ostrzega, że zdjęcia te mają wpływ na narzędzia sztucznej inteligencji, które mogą generować niebezpieczne treści, a także powodować znaczne nadużycia m.in., szerzenie fake news’ow.

Oczyszczenie bazy danych z tego rodzaju treści nie jest takie proste, dlatego Stanford Internet Observatory wzywa do podjęcia bardziej radykalnych działań. Apelują do osób korzystających z danej bazy LAION-5B, aby usunęły niebezpieczne treści lub pracowały z pośrednikami, aby oczyścić te materiały.

– Legalne platformy mogą zaprzestać oferowania wersji do pobrania, zwłaszcza jeśli są one często wykorzystywane do generowania szkodliwych obrazów i nie posiadają zabezpieczeń blokujących – podkreśla główny technolog Stanford Internet Observatory, David Thiel, który jest również jednym z autorów raportu.

Bądź na bieżąco z najważniejszymi informacjami subskrybując nasz codzienny newsletter 300Sekund! Obserwuj nas również w Wiadomościach Google.

Firmy dokładnie sprawdzają bazy danych

Z kolei firma Stability AI, twórca modeli tekst-obraz Stable Diffusion, zadeklarowała podjęcie działań mających na celu minimalizację ryzyka nadużycia poprzez filtrację treści. Podobne działania podejmuje LAION, wprowadzając rygorystyczne filtry, choć według raportu, wcześniejsza konsultacja z ekspertami mogłaby poprawić skuteczność tych działań.

Wiele generatorów tekst-obraz pochodzi z bazy danych LAION, choć nie zawsze jest jasne, które dokładnie. OpenAI, twórca Dall-E i ChatGPT, powiedział, że nie korzystał z LAION i tak dostroił swoje modele, aby odmawiały żądań dotyczących treści seksualnych z udziałem nieletnich.

Google zbudował swój model Imagen na podstawie zbioru danych LAION, ale zdecydował się nie udostępniać go publicznie w 2022 roku po audycie bazy danych, który „odkrył szeroki zakres nieodpowiednich treści, w tym obrazy pornograficzne, rasistowskie obelgi i szkodliwe stereotypy społeczne”, podano.

Polecamy także:

- Sztuczna inteligencja wybierze prezenty na Święta. Pomoże też w zakupach online

- Nowe wyzwania Google. Sztuczna inteligencja wprowadza w błąd

- Globalny sojusz ws. bezpieczeństwa AI. Sztuczna inteligencja zostanie uregulowana